Алаяқтар жасанды интеллект көмегімен қазақша «сөйлей» бастады

Алаяқтар жасанды интеллект көмегімен қазақша «сөйлей» бастады. Осылай деген ІІМ өкілдері қазақстандықтарға ескерту жасады. Құқық қорғаушылардың айтуынша, әккілер нақты адамның дауысын салып, банк немесе полиция қызметкері және жақын туыс ретінде қоңырау шалып, ақпарат сұрауы мүмкін. Сондай-ақ, олар deepfake технологиясын қолданып, танымал тұлғалардың немесе туыстарыңыздың жалған бейнежазбасын да жібере алады. Осы ретте, полицейлер азаматтарға күмән тудыратын хабарламалар мен қоңырауларға аса мұқият болуға кеңес беріп, жеке деректерді ешкімге бермеуді ескертеді.

Армангүл Тоқтамұрат

Автор

Армангүл Тоқтамұрат

Сондай-ақ оқыңыз

Барлығы

Алматыда халықаралық көрме ашылды

06.03.2026, 20:59

Бүгін Ақ Паралимпиаданың алауы тұтанады

06.03.2026, 20:57

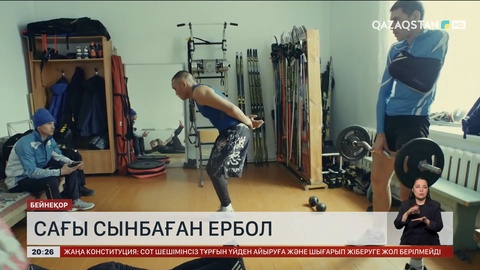

Тағдыр сынына мойымаған, қайсар мінезімен көпке үлге болған спортшы

06.03.2026, 20:54

Боччадан республикалық турнир өз мәресіне жетті

06.03.2026, 20:51

Әлем әйелдермен әдемі

06.03.2026, 20:50

Мемлекет басшысы халықаралық Қызыл Крест комитетінің президентімен кездесті

06.03.2026, 20:21

Мемлекет басшысы мереке қарсаңында бір топ қыз-келіншекті марапаттады

06.03.2026, 20:17

Президент мерекелік концертті тамашалады

06.03.2026, 20:16